この技術が手に取りやすくなれば、撮影した練習や試合の映像から、フォームの修正や怪我の予測が手軽にできるようになるかもしれない。

3月3日、東京大学の中村仁彦上席研究員・名誉教授は、同大学大学院工学系研究科の社会連携講座「ヒューマンモーション・データサイエンス」で行っている研究の成果を発表した。社会連携講座とは、公共性の高い課題を産学で共同研究しようという講座または研究部門のこと。

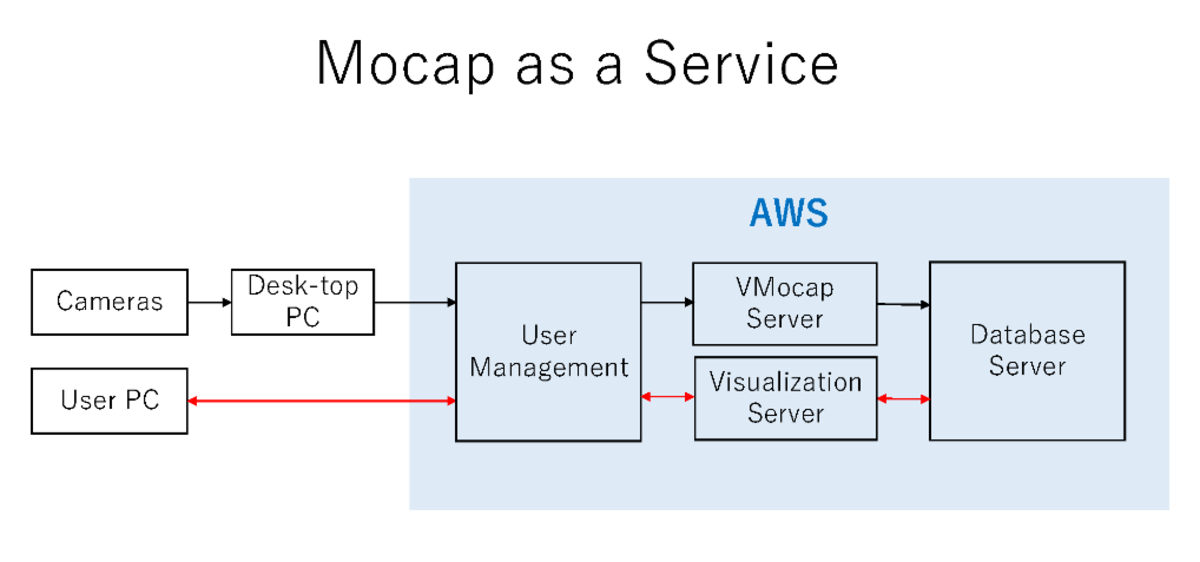

その内容は、特殊なスーツの着用や人的な情報処理の介在なしに、複数台カメラで撮影した人が動く5秒間の映像を約10分後には骨格や筋の活動をグラフや3次元映像にして見ることができるシステムをクラウド上に実装し、一連のサービスとして利用できるものになった、とのこと。これを中村氏は「Mocap as a Service」と表現する(Mocapとは、モーションキャプチャーの略)。データ処理にエンジニアの人手を一切必要としなくなったため、モーションキャプチャー(人やモノの3次元の動きをデジタルデータ化すること)利用の裾野が広がる。

従来のモーションキャプチャー技術では、マーカーと呼ばれる人の関節の位置を特定するための装具や筋電計を身に着ける必要があった。また、映像から得られたデータから骨格や筋の動きを計算し3次元映像として再構成するためには、エンジニアが介在しデータ処理を行う必要があった。

「従来ならマーカーを取り付ける準備に少なくとも1時間以上、計算から映像化まで2〜3週間はかかっていました。計算と計算を矛盾なくつなぐためにも人手が必要でした。これをなんとかしたいとこれまで取り組んできました。

今回のシステムを使うと、5秒間の運動であれば撮影から約10分で解析結果が出ます。ビデオ映像から計算、さらにデータベース化し、映像までつくってグラフも表示するところまでをノンストップで、人手を介さずに行う、ひとつのソフトウエア“Mocap as a Service”として完成した、と考えています」(中村氏)

運動情報のデータを蓄積していくデータベースを備えたことで、検索することもできる。

3次元映像化には、クロスプラットフォーム(PC、携帯端末、ヘッドマウントディスプレイなど)で使えるゲームエンジンを利用した。このサービスが一般化・普及すれば、スポーツ選手だけでなく多くの人々の健康増進に寄与することができるだろう。

今後の課題は、さらに計算の効率化・高速化を図ること、チーム競技の複数選手の同時モーションキャプチャーができるようにすることなど。スポーツ・データサイエンティストの養成などの研究にも取り組み、並行して東大発スタートアップでの商用化を目指す。

取材・文/TORCH編集部